메모리 80GB, 700W 및 60 TFLOPS. GPU 생성 호퍼를 기반으로 한 NVIDIA H100 가속기를 발표했습니다

2 층 GPU가 회사를 보여 주었지만 회사는

예상대로 NVIDIA는 오늘날 호퍼 아키텍처와 해결책을 도입했습니다. 이 소식을 작성할 때 NVIDIA는 2 크기의 GPU를 보여주지 않았지만 프레젠테이션은 아직 끝나지 않았습니다.

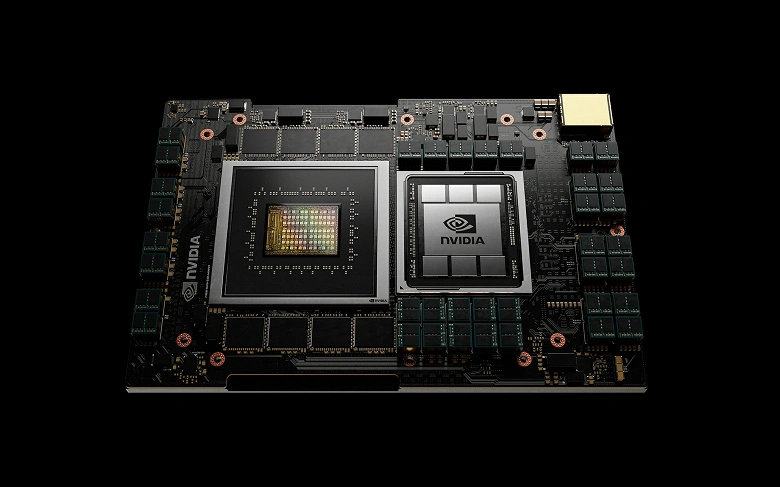

따라서 현재 호퍼 생성의 유일한 해결책은 800 억 개의 트랜지스터로 구성된 GPU GH100입니다. NVIDIA H100 가속기를 기반으로합니다. GPU 자체의 매개 변수는 아직 우리에게 공개되지 않았지만 가속기의 특성은 알려져 있습니다.

알 수 있듯이 폼 팩터에 따라 이러한 특성은 다소 다릅니다. 수석판에는 15,872 개의 CADA 커널이 있습니다. 초기 데이터로 판단하면 GPU GH100 자체 전체 구성으로 18 개의 432 개의 커널이 포함되어 있습니다. 보시다시피 호퍼 아키텍처는 SM 블록의 ALU 수의 두 번 암페어 게임 아키텍처와 유사합니다.

두 버전의 메모리는 두 버전의 80GB이며, 이는 2 ~ 3TB / s의 대역폭이있는 HBM3입니다. 이전 버전의 TDP는 믿을 수없는 700W이며 PCIe 5.0의 수정은 두 배 더 작은 것입니다.

SXM5 버전의 성능은 30 TFLOPS (FP64), 60 TFLOPS (FP32)에 도달하고 있으며 24 및 48 TFLOP의 PCIe 5.0 버전이 있습니다. 동일한 순서로 900 또는 600GB / s의 데이터 전송 속도를 제공하는 NVLINK 인터페이스를 주목할 가치가 있습니다.

새로운 아키텍처는 4 세대의 시장 및 텐서 코어를 사용하며, 여러 가지 기계 학습 작업에서 이전 세대보다 9 배 빠릅니다. 별도로 NVIDIA는 개발자가 다양한 산업 분야에서 동적 프로그래밍 알고리즘을 가속화하고 질병 진단, 양자 모델링, 컬럼 분석 및 라우팅 최적화를위한 작업 프로세스를 가속화하는 코드를 작성하는 데 도움이되는 새로운 DPX 명령어를 표시합니다.

호퍼 솔루션 기반 시스템은 3 분기에 NVIDIA 파트너가 사용할 수 있습니다.