AWSがAmazonEC2P4dインスタンスの提供を発表

Amazon Web Services(AWS)は最近、NvidiaGPUを搭載したAmazonElastic Compute Cloud(Amazon EC2)P4dインスタンスの一般提供を発表しました。インスタンスは、特定の機能を備えた特定の一般的なリソースがユーザーに提供されるときに、クラウドコンピューティングでそのようなサービスモデルを実装するサービスとしてのインフラストラクチャ(IaaS)を提供するクラウドで実行される仮想マシンのインスタンスとして理解されることを思い出してください。 AWSは、P4dインスタンスが前世代のP3インスタンスの3倍のパフォーマンスと2.5倍のGPUメモリをマシン学習およびスーパーコンピューティングワークロードに提供すると推定しています。そして、これらすべてが低コストで実現します(構成と料金プランによっては、最大60%の節約になります)。

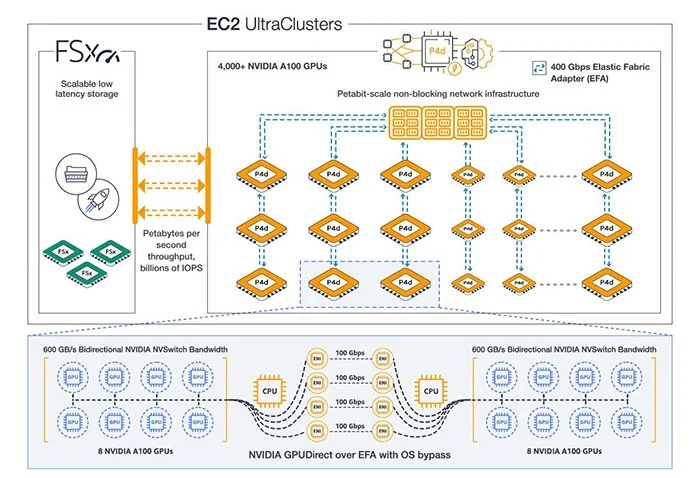

P4dインスタンスは、8つのNvidia A100 TensorコアGPUと400Gbpsネットワーク(P3の16倍)へのアクセスを提供します。 AWS Elastic Fabric(EFA)とNvidia GPUDirect RDMA(リモートダイレクトメモリアクセス)を使用すると、顧客はP4dインスタンスをEC2UltraClusterに集約できます。これにより、高性能ストレージ用にAmazon FSxと統合されたAWSのノンブロッキングペタビットスケールネットワークインフラストラクチャを活用して、P4dインスタンスを4,000を超えるA100 GPU(他のクラウドプロバイダーの2倍)にスケーリングすることで、スーパーコンピューターグレードのパフォーマンスにアクセスできます。光沢。

AWSがAmazonEC2P4dインスタンスの提供を発表

改善されたP4dパフォーマンスは、機械学習モデルのトレーニングをスピードアップし、追加のGPUメモリは、顧客がより大きく、より複雑なモデルをトレーニングするのに役立ちます。お客様は、Amazon Elastic Kubernetes Service(Amazon EKS)またはAmazon Elastic Container Service(Amazon ECS)のライブラリを備えたAWS Deep Learning Containersを使用して、P4dインスタンスでコンテナ化されたアプリケーションを実行できます。制御を強化するために、顧客はAmazon SageMakerを介してP4dインスタンスを使用できるため、開発者とデータサイエンティストは、機械学習モデルを迅速に構築、トレーニング、および展開できます。 P4dは、TensorFlow、PyTorch、Apache MXNetなど、すべての主要な機械学習フレームワークをサポートしているため、お客様はアプリケーションに最適な環境を柔軟に選択できます。