80 GBのメモリ、700 W、60 TFLOPS。 GPU発電ホッパーに基づいてNVIDIA H100アクセラレータを発表しました

2停止GPUが会社を示していない間

したがって、予想どおり、NVIDIAは今日のホッパーアーキテクチャとそれに基づいてソリューションを導入しました。このニュースを書く際は、NVIDIAは2サイズのGPUを表示しませんでしたが、プレゼンテーションはまだ終了していません。

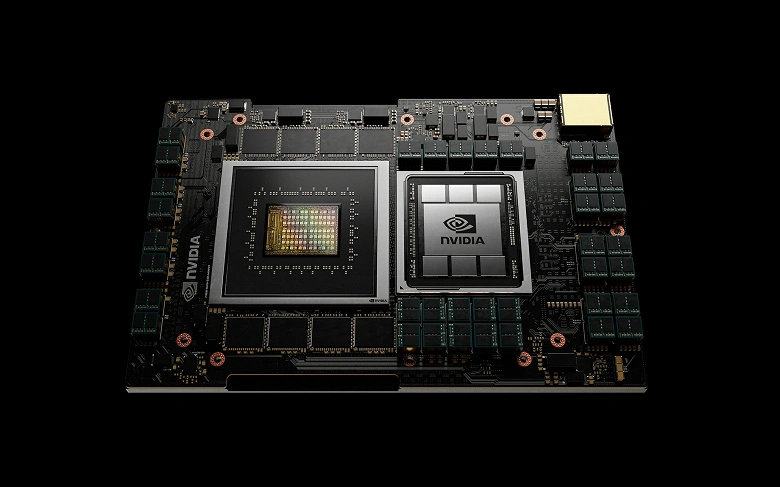

そのため、現時点では、ホッパー生成の唯一の解決策は、80億トランジスタからなるGPU GH100です。それはNVIDIA H100アクセラレータに基づいています。 GPU自体のパラメータはまだ私達に明らかにされていないが、アクセル化器の特性は知られている。

あなたが見ることができるように、フォームファクタに応じて、これらの特性はいくらか異なります。上級版には15,872のCADAカーネルがあります。早期データで判断すると、GPU GH100自体は完全な構成では18の432カーネルが含まれています。ご覧のとおり、ホッパーアーキテクチャは、SMブロック上のALUの数の2倍のAMPEREゲームアーキテクチャと似ています。

80 GBの両方のバージョンのメモリ、およびこれは2または3 TB / sの帯域幅を持つHBM3です。古いバージョンのTDPは700WのTDPが信じられないものですが、PCIe 5.0の変更は2倍の小さいです。

SXM5バージョンの性能は30TFLOPS(FP64)、60TFLOPS(FP32)、およびPCIe 5.0バージョンの24および48 TFLOPSにそれぞれ到達します。同じ順序で900または600 Gb / sのデータ転送速度を提供するNVLinkインターフェースに注目する価値があります。

この新しい建築は、4世代の市場とテンソルコアをもたらします。別々に、NVIDIAは新しいDPX命令のセットをマークします。これにより、開発者はさまざまな業界で動的なプログラミングアルゴリズムをスピードアップするためのコードを書くのに役立ち、疾病、量子モデリング、列分析、およびルーティングの最適化のための作業プロセスを高速化します。

ホッパーソリューションベースのシステムは、第3四半期のNVIDIAパートナーに利用可能になります。